デンソーウェーブは「2017国際ロボット展」のブース内でディープラーニングと予測学習を使った双腕のマルチモーダルAIロボットアームを展示し、報道関係者向け説明会とデモンストレーションを行った。このロボットアームは初お披露目となる。

マルチモーダルAIロボットアームは、ロボット技術としてはデンソーウェーブが従来から実戦投入している産業用ロボットの技術を使ったものだが、「汎用性」を追求している点と、ディープラーニングと予測学習を利用している点が新しい試みとなる。

タオルをたためるロボットの意味と意義

まず、マルチモーダルAIロボットアームにおける「マルチモーダル」の意味だが、画像、角度、力覚、速度などの複数の要素の連携を意味する。ニューラルネットワークから見ると、これらの要素をデータ「一式」として認識、判断することから付けられている。

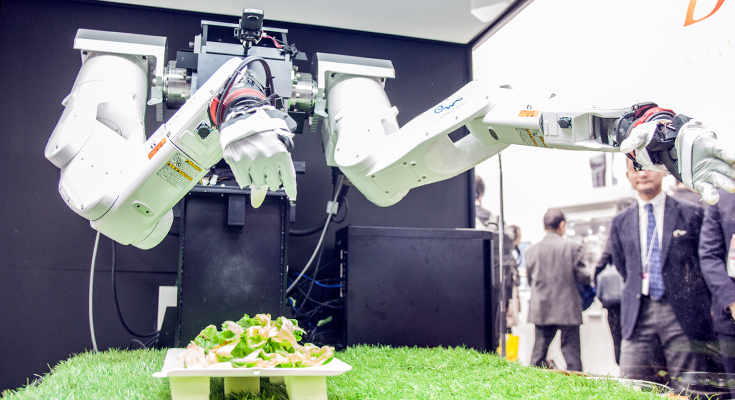

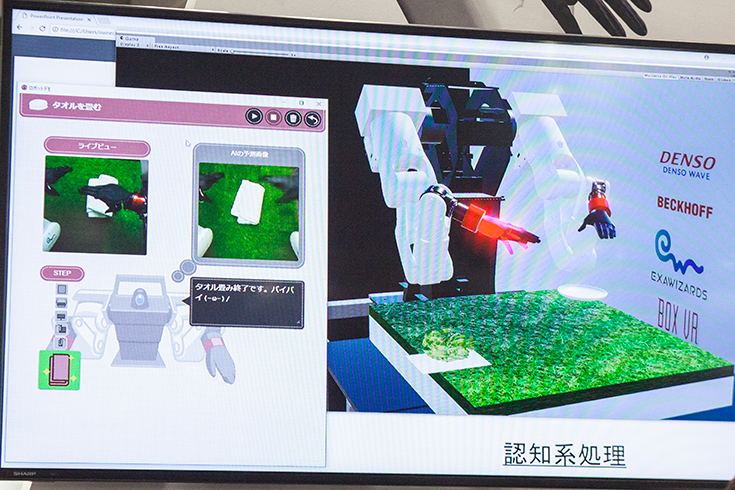

デモでは畳む最後の段階で失敗してしまったが、この作業のティーチングはわずか10回以下の作業で学習したという。

■マルチモーダルAIロボットアームがタオルをたたむ

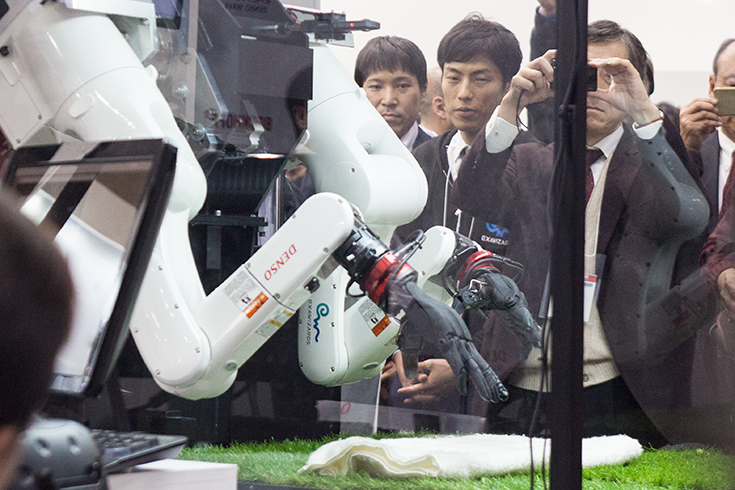

ロボットアームの開発はデンソーウェーブ、RPC(CPUやGPUを搭載)はベッコフオートメーション、人工知能はエクサウィザーズが担当、多指ハンドをイクシーから提供を受け、ディープラーニングや予測学習はAIロボットの研究で知られる早稲田大学理工学術院の尾形哲也教授の研究を活用している。これだけの組織が連携したからこそ短期間で実現したと言う。なお、発表されたマルチモーダルAIロボットアームはプロトタイプなので、現時点で製品化の具体的な予定はない。

工場などで使用されている通常の産業用ロボットアームは、専用のハンドを装着して、決められた作業を高速に正確にこなすことが求められる。すなわち業務をこなすための専用のロボットがほとんどだ。デンソーウェーブ社が手がけてきたこれまでのロボット製品もそうだった。そのため、作業にあわせて最適なハンドの形状に換装するのが常だった。一方、人間の腕の能力の強みは多様なことができる、すなわち「汎用性」だ。産業用ロボットアームで実績のあるデンソーウェーブのような企業が、汎用性の高いロボットアームの研究開発を行う点が興味深い。

そしてもう一点が、ディープラーニングや予測学習を使っている点だ。デモンストレーションではタオルを畳む作業を行った。今回はプログラミングやアプリケーションを使わず、ロボットが「タオルを畳む」という動作を学んだ。ロボットの前面には全天球カメラが装備されている。

動作はVRデバイスを使って人間がタオルを畳む作業を見本として行うことで、その動作をロボットが学習する「ティーチング」で実現している。

なお、このティーチングの作業も実演された(後述)。

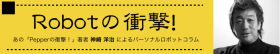

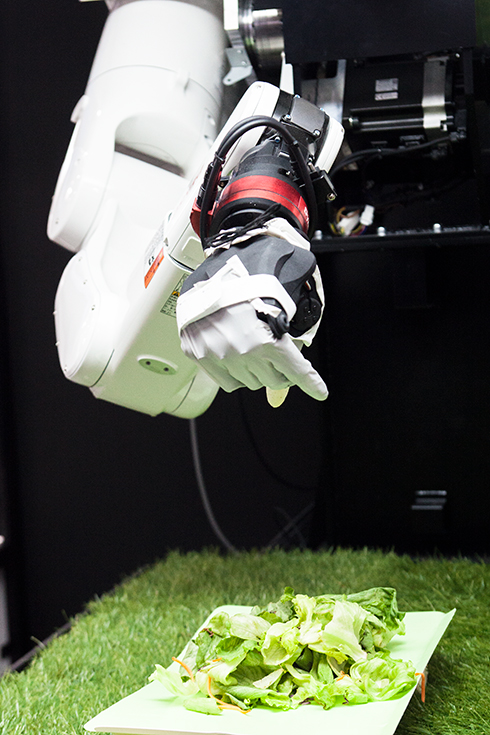

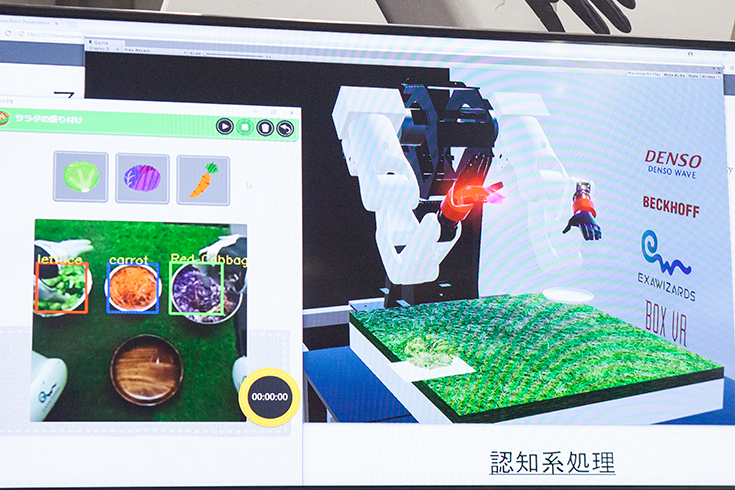

もうひとつのデモでは、マルチモーダルAIロボットアームがサラダの盛り付けを行った。ロボットは柔らかい野菜を状況に応じて手加減しながら持つことが要求される。この作業もVRとディープラーニングを活用してロボットに学習させたものだ。

■マルチモーダルAIロボットアームがサラダを盛り付ける

プログラミング不要、VRでロボットに覚えさせる方法とは

最後のデモは、ロボットに作業を教えるためのティーチング作業。

汎用のVRコーグルを使用し、作業者がロボットの視点で画像を見る。実際の野菜の映像から仮想空間にも野菜が置かれているが、それをつかむ動作をすると、全く同じ動きをロボットがほぼ同時にトレースする。この作業の一連の画像からロボットは作業を学習していく。

深層学習には早稲田大学理工学術院の尾形教授の研究が活かされている。ロボットはカメラで机上に置かれたタオルを見たとき、このタオルはこのように畳めばいいのだろう、こう畳むべきだという「予測」の画像が表示され、それを実現するための動作を行う。(実演では実際にカメラが見ている映像と、タオルを畳んだらこうなるという予測画像が表示されるが、予測画像はとてもリアルな画像にもかかわらず、それはニューラルネットワークが描いた架空のものだと言う)。

タオルの位置は正確にきれいに置かれている必要はなく、人間と同様、タオルに少し持ち上がっている部分があれば、そこから上手にタオル下に指を入れられる。

■マルチモーダルAIロボットアームのティーチングはVRで

人間が作業の見本を見せて、ロボットがそのとおりに行う作業を機械学習することを「模倣学習」とも呼ぶ。時系列の要素が加わるRNN(リカレント型ニューラルネットワーク)が使われる。学習の経験から次の瞬間の画像はどのようになっているべきだ、そのためにはどう動けばいいか、ということをロボットが自律的に判断する点が面白い。

驚きなのが、学習が短時間で実現していることだ。通常、ディープラーニングや強化学習の分野では、ロボットに作業を覚え込ませるにはその作業を行う何千通りもの画像データが必要なのかと想像していたが、今回の実演ではサラダの盛り付けでは30回程度、タオル畳みでは10回以下のティーチングで手順を学習できると言う。

汎用ロボットの高度化だけでも素晴らしいニュースだが、深層学習(予測学習/模倣学習)によって、簡単にロボットが動作を修得できるようになる未来がいよいよ見えてきた。

ABOUT THE AUTHOR /

神崎 洋治神崎洋治(こうざきようじ) TRISEC International,Inc.代表 「Pepperの衝撃! パーソナルロボットが変える社会とビジネス」(日経BP社)や「人工知能がよ~くわかる本」(秀和システム)の著者。 デジタルカメラ、ロボット、AI、インターネット、セキュリティなどに詳しいテクニカルライター兼コンサルタント。教員免許所有。PC周辺機器メーカーで商品企画、広告、販促、イベント等の責任者を担当。インターネット黎明期に独立してシリコンバレーに渡米。アスキー特派員として海外のベンチャー企業や新製品、各種イベントを取材。日経パソコンや日経ベストPC、月刊アスキー等で連載を執筆したほか、新聞等にも数多く寄稿。IT関連の著書多数(アマゾンの著者ページ)。