NTTドコモが、長年培ってきた音声対話技術やAIエージェントの技術の無償オープン化に舵を切った。

NTTドコモが提供する「AIエージェント基盤」というクラウド・プラットフォームを利用することで、デバイスメーカーは自社製品に高精度な音声アシスタントを導入することができる。また、サービス提供者やデベロッパーはそれらのデバイス上で動作するアプリ(スキル)やサービスを開発し、専用のマーケットプレイスで提供できる。(詳細は前回記事「NTTドコモが「音声会話技術」と「AIエージェント」を無償オープン化!ビジネス活用できる音声デバイスやサービス開発を促進する「AIエージェント基盤」(リンク)」を参照)

第二回の今回は、NTTドコモの秋永氏と山崎氏に、AIエージェント基盤の更に詳しい技術や機能について聞く。

音声会話対応デバイスやサービスを短期間で開発できる基盤

前回も触れたが、「AIエージェント基盤」の大きな魅力のひとつはさまざまな機能がAPIとして提供されることだ。

音声会話対応のデバイスやアプリ、サービスを開発する方法としては、音声認識と音声合成など、別の要素技術をそれぞれ採用して組み込むこともできるだろう。しかし、経験上あまり上手く回らないのが現状だと言う。その開発に時間をかけるのならば、ワンストップで提供される「AIエージェント基盤」を利用してもらい、コンテンツやサービスの作り込みに時間を費やした方がいいのではないかとNTTドコモは提案する。

秋永(敬称略)

「AIエージェント基盤」の最大の特徴は、デバイスメーカー様にとっては、自由度が高くて高精度な音声技術を、とても簡単にデバイスに組み込んで製品化できること、だと思っています。サービス提供者様やデベロッパーの方にとっても自由度の高さは開発のしやすさに大きく影響します。

既存のスマートスピーカーに搭載されている音声アシスタントは、ユーザーの会話の記録や履歴など、詳細のデータを開発者が利用できるようにはできていません。「お客様が何と言ったのか」「何について話をしてきたのか」という詳細から判断して細かなシナリオを構築して運用していくには、「AIエージェント基盤」のように、最初からビジネスで活用できるように設計されたオープンな環境が必要になります。音声認識した結果や履歴等、詳細のデータをフィードバックして、それを開発者が活用できれば、テストやデバッグ、学習等、幅広く活用できるので、より精度の高い、利用価値のあるサービスへと展開していけるだろう、と私達は考えています。

既にチャットボットを導入していたり、AIを活用した分析サービスなどを持っている企業であれば、音声の入出力に「AIエージェント基盤」を通すだけで、NTTグループの音声会話技術を自社のサービスに組み込んでユーザーと会話することができます。

山崎(敬称略)

ユーザーが「いま何を知りたいのか」「その質問にどのような意図があるのか」ということをくみ取るには、複数の会話の履歴を解析することが重要です。NTTドコモの多目的対話エンジンは一問一答だけでなく、比較的長い会話を解析したり、履歴から意図を解析する機能に優れていて、高精度な回答を提供しやすいと考えています。

シナリオ対話と意図解釈

現在市販されているスマートスピーカーは一問一答が基本だ。ひとつの質問に対して回答すると、その時点で会話は終了してしまう。しかし、人と人との会話の多くは、複数のやりとりを繋げることで、お互いに会話の意図をより深く解釈するものだ。「AIエージェント基盤」の「多目的対話エンジン」はその点にも秀でている。

例えば、渋谷に住んでいる人が、自室でスマートスピーカーに「天気を教えて」と聞いた場合、”渋谷の今日の天気”が適切な回答になる。次に、「明日名古屋に行くんだけど」と告げて、ご当地グルメや観光地の情報を質問したとする。スマートスピーカーは名古屋のご当地情報を教えてくれるだろう。そのあと「天気はどう?」とたずねた場合、”明日の名古屋の天気”を答えてくれるかどうかが、AIエージェントの会話の精度が問われるところとなる。

山崎

「AIエージェント基盤」を使えば、履歴を解析したり、分岐のあるシナリオに対応できるので、AIエージェントはユーザーが今「いつ」「どこ」の情報が欲しいと思っているのかを理解することができます。そういった機能をAPIで提供しているので、開発者はそれを活かして、アプリやサービス、デバイスを簡単に開発できるのです。

秋永

「シナリオ対話」と「意図解釈」は、自然言語プラットフォームのコア技術のひとつです。「シナリオ対話」とはまさに、ユーザーとAIエージェントの間で交わした前回のやりとりを考慮しつつ、直近のユーザーの質問に基づいて回答を決定する、ということです。エージェントは予め用意したシナリオに沿ってユーザーとの会話を進めるものの、シナリオにない内容になった場合でも、雑談対話や知識Q&Aによって、不自然な対話にならないように回答することができます。これら柔軟で多様なシナリオは「拡張AIML」(The Artificial Intelligence Markup Languageの略称)というXMLベースの言語を使って書いています。天気やニュースなどの外部情報を取得して提供する連携機能や発話する文章の曖昧性を吸収する文章正規化機能も備えています。

私達は自由度が非常に高い「拡張AIML」の仕様を、3月末を目途に一般に公開しようと思っていますので、併せてご利用ください。

ビジネス利用に自由度が高い理由

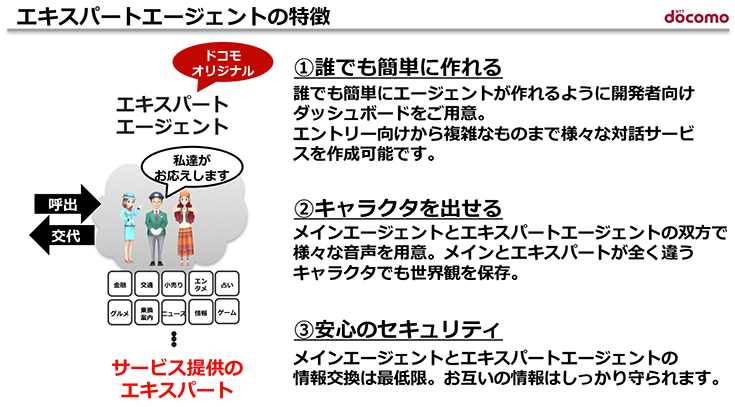

スマートスピーカーを例にとると、ビジネスでの利用では「ウェイクワード」も課題になる。ウエイクワードとは「アレクサ!」や「OK、グーグル」など、スマートスピーカーを通じて音声アシスタントに話しかけるときの起動ワードだ。自社製品やサービスに組み込むときは、ウェイクワードを自社名や製品名、AIエージェントのキャラクター名にしたいと考えるのが自然だ。「AIエージェント基盤」の「エキスパートエージェント」(スキル)ではその点にも配慮がされている。

山崎

「AIエージェント基盤」では、各社が自由にウェイクワードを設定できます。またウェイクワードだけでなく、音声アシスタント(音声エージェント)の性別、声、言葉遣いなど、人格というかキャラクターの設定も行うことができます。「AIエージェント基盤」の「エキスパートエージェント」には大きく分けて3つの特徴がありますが、そのうちのひとつに「キャラクターを出せる」点が挙げられます。既にオリジナル・キャラクターを持っていれば、それに合わせた音声アシスタントをデベロッパーが開発し、サービスとして提供することもできます。

編集部

つまり、キャラクター・ビジネスも展開できるということですね

山崎

はい。音声エージェントの音声合成(コンピュータによる発話)は、NTTグループのテクノロジーを使って51種類の音声を用意しています。これを活用すれば、好きなタイプの声で流ちょうな日本語でユーザーと会話することができると思います。

また、声優など、実在する人の声を音声合成に使うこともできます。最低約4時間、スタジオなどで大量に録音した音声を元に、ほぼ同じ声で話す音声合成システムを提供することも可能です。アニメやドラマなどのキャラクターの声で話すAIエージェントと会話するサービスでビジネス展開することができます。

また、ウェイクワードについては必ず必要というわけでもありません。ロボットやカメラのように、人の顔を認識して話しかけられたことが解れば、自分への会話だと判断する、そんなしくみも実現可能です。ユーザーとの接点、すなわちUX部分では使い勝手を低下させたり、決まったウェイクワードが必要、と言った制限を設けることなく、開発者が自由に開発できることを重視したものになっています。

デバイスとサービス両輪で活性化

システムやサービスが普及する鍵は、ハードウェアとソフトウェア、すなわちデバイスとサービスの両方が活性化するエコシステムを構築していくことだ。すなわち、デバイスが増えなければ、サービス利用者も増えない。サービスが充実していないと、デバイスに魅力を感じない。

これを踏まえ、NTTドコモは「AIエージェント基盤」を使って開発したアプリやサービスは、AIエージェント基盤に対応しているデバイスならどれでも利用できるしくみをとる。デベロッパーが開発したアプリやサービスを広く活用できるマーケットプレイスも用意し、デベロッパーがビジネス展開できるようにしている(登録審査を受付中)。

秋永

「AIエージェント基盤」で簡単な音声会話システムが導入できるようになれば、それを使ったサービスやデバイスがたくさん登場したり、ユーザーが本当に使いやすいものも創出されやすくなるでしょう。その結果、音声会話サービス市場が活性化して、ビジネスが創造できて、市場が賑わってくれれば嬉しいと考えています。

編集部

どんなデバイスが「AIエージェント基盤」に最適だとお考えですか?

秋永

物理的にキーボードやタッチパネルなどの入力装置が付けられない、付けにくい機器には音声操作は有効な入力方法になります。次にタッチパネルなどでユーザーが画面で選択操作をおこなうようなものでも、選択したいものを探すのに手間がかかるケースも多く見られます。居酒屋さんでフライドポテトを注文しようと思ったけれど、どのカテゴリーにあるか解らない、ページをめくってもめくっても出てこないなどの場合です。

音声で「フライドポテトが食べたい」って発話するだけで注文の画面を表示する機能を追加で組み込むこともできるでしょう。音声入力は画面操作やタッチ方式と排他である必要はありません。音声によって操作がシンプルになる、その機能が気軽に組み込めるのであれば、ニーズは大きいと考えています。

音声のUI/UXの知見やノウハウの蓄積は始まっている

秋永

ご案内やご質問に回答するニーズはどんどん増えています。スーパーなどでも無人レジが増えてきたものの、ちょっとした質問に自動で対応できるシステムが欲しい、という場合にも音声会話システムが気軽に導入できれば、無人レジの利用者を増やすことに繋がるかもしれません。

また、対話そのものがビジネスになる可能性があると考えています。ノベルゲームの音声読み上げ版であったり、AIエージェントと対話することで癒しに繋がるもの、対話によって気分や感情の動きや健康状態を把握する、といったものも面白いですね。

山崎

バーチャルYouTuberが注目されていますが、将来は音声AIエージェントがそんな役割を担っていくことも考えられるのではないかと感じています。

私は他に、チャットボット向けプラットフォームの研究開発も担当していますが、聞かれた質問にただ答えるだけではなく、AIエージェントが言い回しを少し変えて回答してみたり、答えと一緒に別の選択肢を提案することで、会話の幅が大きく拡がったり、クオリティの向上を実感することもよくあります。こういった知見が蓄積されていくとやがて、デザインやクリエイティブ系の学問や知識として根付いていく・・そしてその流れは既に始まっていることを感じます。

秋永

スマートフォン用のUIやUXが研究され、秀でたクリエイターやデザイナーが登場し、ユーザーの使い勝手が飛躍的に向上しました。それが学識として教えるビジネスが生まれたりしてきたように、自然会話するデバイスやサービスがたくさん登場すれば、音声エージェント用の声や話の流れに対してのUI/UXが研究され、シナリオライティングや教育ビジネス等への展開が、もしかしたら見られるんじゃないか、そんな拡がりを期待しています。

海外ではスマートスピーカーが大ヒットしていることもあって、ビジネスシーンでも音声会話デバイスはソリューションとして注目されていくかもしれない。NTTドコモの「AIエージェント基盤」の登場によって、音声会話デバイスやサービスの開発が飛躍的に加速する可能性が見えてきた。

NTTドコモとロボットスタート主催の「ドコモのAIエージェント基盤「セバスチャン」勉強会【#1】(2018/03/19 19:00〜)」と「【#2】 (2018/03/27 19:00〜)」でAIエージェント基盤について紹介と解説が行われます。