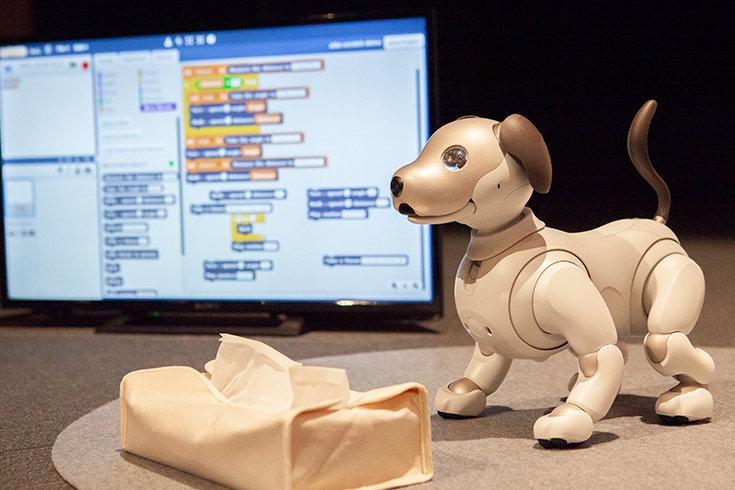

ソニーはaiboの新サービスについて報道関係者向けの発表会を開催した。その中で2019年8月より、待望の「ソフトウェアAPI」の提供を開始することが明らかになった。aiboの多様な利用シーンの実現に向け、他の企業や団体、教育機関、個人を含む様々な商品・サービス等との連携を推進するため、aiboのソフトウェアAPIを無償で一般公開する。プログラミングをaiboに反映させることが可能になる。プログラミングした例として、aiboがティッシュぺーパーを取るデモが行われた。

■aiboがティッシュをとりだすデモ

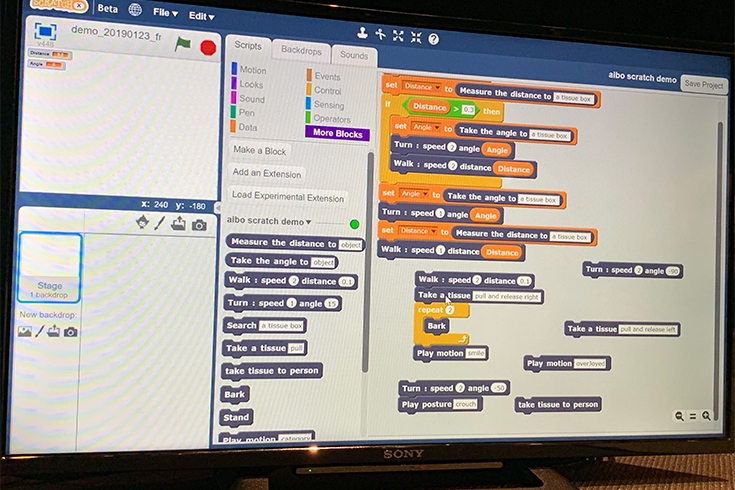

API? スクラッチってなに?

APIとはアプリケーション・プログラミング・インターフェースの略で、これを使うと開発者がaiboの動きをプログラムすることができる。今回参考展示されたのは、ドラッグ&ドロップ操作が中心で初心者でも使いやすい「Scratch(スクラッチ)」ベースのもので、これからプログラミングを学習する子どもや、初めてプログラミングを行う人でも簡単にチャレンジできそうだ。

スクラッチツールは「前に歩く」「回る」「喜ぶ」「首を傾げる」など、行動を指定する「ブロック」をドラッグ&ドロップして組み合わせることで、aiboの行動をプログラミングすることができる。今回のティッシュペーパーのデモは、もっともシンプルなもので、aiboは口を開けて顔を下に下げ、口を閉じて顔を上げることでティッシュを取り出している。また、くわえたティッシュを右に投げるか、左に投げるかもブロックで指定できる。

ティッシュペーバーをとるプログラム

デモのプログラミングではティッシュボックスの位置は決め打ちで、人が位置を合わせてあげる必要がある。実際には、画像認識機能を使ってティッシュボックスの位置を特定し、そこに近付いてティッシュペーバーを確認してから取り出す動作をした方が確実性が上がるが、初期リリース時にそこまでの機能やブロックが用意できるかは未定だ。

また、現状では、作成したプログラムを「実行」したときにaiboはプログラミングで指示された通りの動きをするが、ユーザーの視点で見ると「特定の音を聞いたらaiboが敬礼する」とか「特定の場所をなだられたら決めポーズをする」など、aiboと一緒に生活している中で、プログラミングした動作が反映されるとなおうれしいだろう。こうしたことは将来実現できるようになると予想されるがそれを実現するための第一歩として、まずはaiboの開発環境(Web API)の無償提供がはじまることは大いに歓迎したい。