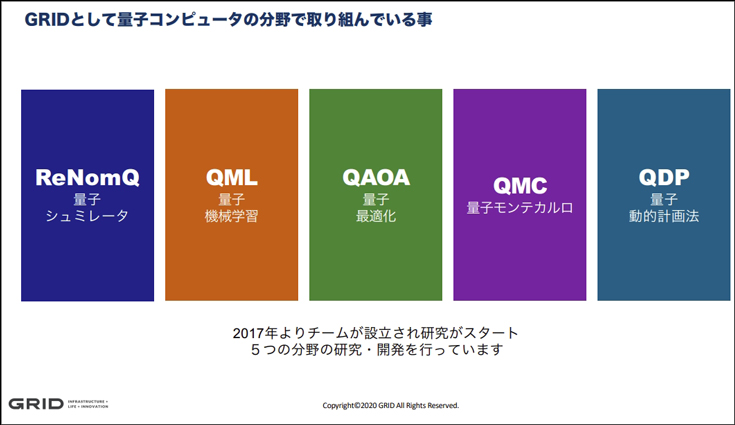

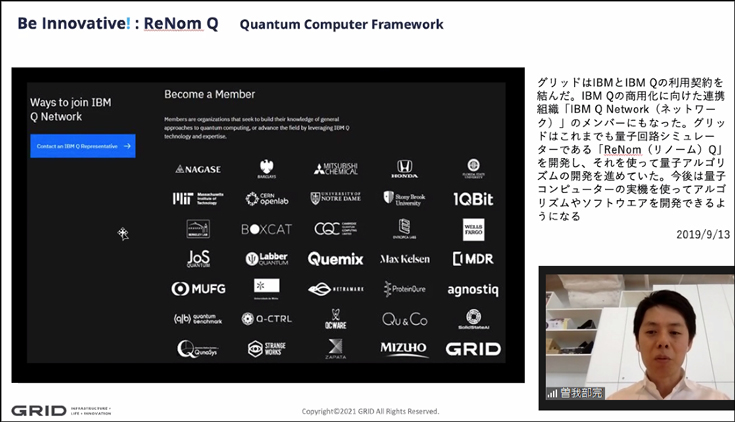

株式会社グリッドの量子アルゴリズム研究チームは、量子機械学習器は過学習しにくいという性質を、詳細な数値実験と統計的機械学習の理論を通して示すことに成功した。また、この成果を論文として発表し、世界的に権威ある学術雑誌に掲載されたことを発表した。

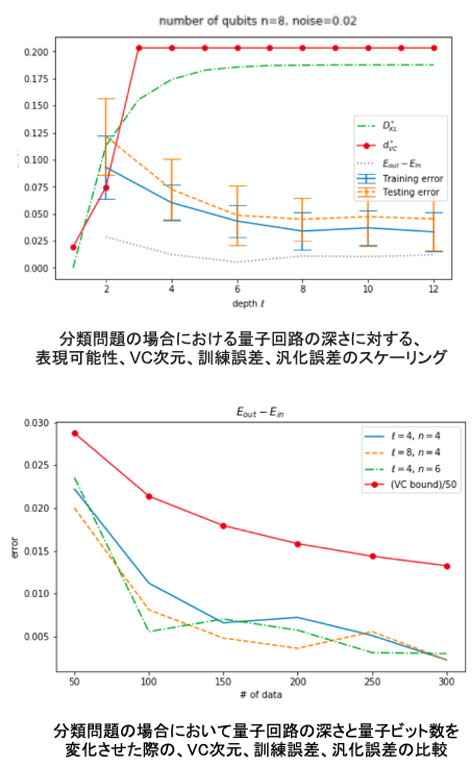

今回の発表のポイントは大きく2点。ひとつは「量子コンピューティングではニューラルネットワークで課題となっている過学習が発生しにくい」ことを実験で実証したこと。もうひとつは、従来コンピュータでは過学習を防ぐためのVC理論の公式があるが「量子コンピューティングにおけるVC次元境界の計算方法(公式)」を初めて提示して発表したこと。

掲載された学術雑誌は「ACM Transactions on Quantum Computing」で、世界最大の国際コンピュータサイエンス学会 ACM(Association for Computing Machinery)が発刊している。

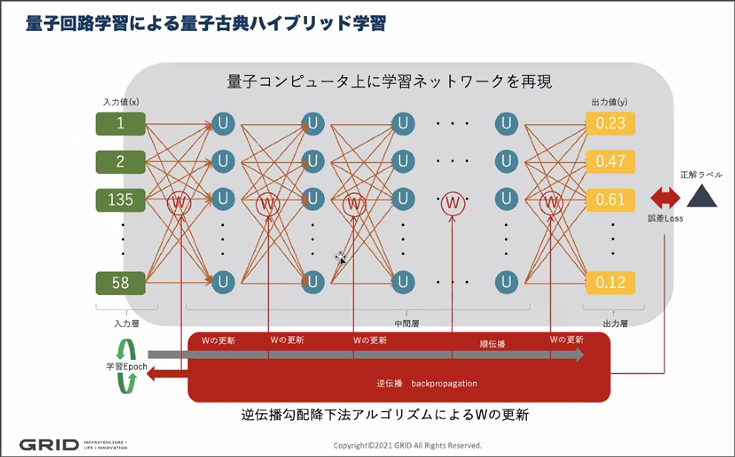

量子コンピュータは現在のコンピュータ(古典コンピュータ)が計算できない大規模演算を短時間でおこなう超高速性能が期待されているが、現在の利用環境が限られていて、なおかつ四則演算などの計算に適さず、汎用性が低い。そのため、量子コンピュータは活用に適した分野にのみ特化して利用され、しばらくは従来コンピュータと量子コンピュータをハイブリッドで運用する方法が現実的と見られている。今回の発表は、AI機械学習を量子コンピュータで行い、学習したアルゴリズムを従来コンピュータのAI推論に活かすなどのハイブリッド活用の可能性が広がる、という意味でも大きく影響を与えるものになると考えられる。

「過学習」はディープラーニングの課題のひとつ

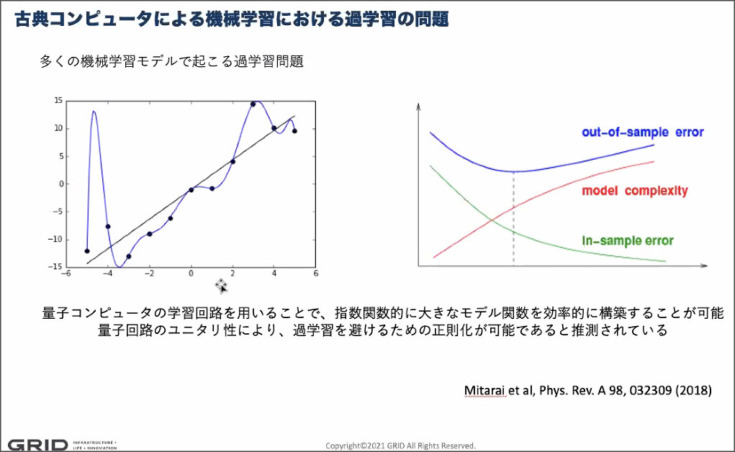

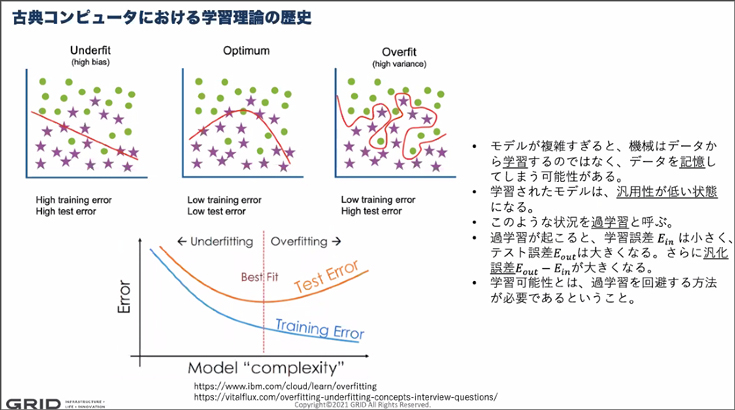

ニューラルネットワークやディープラーニング(AI)の社会実装が進み、より複雑な課題解決への活用が期待されている。一方で機械学習においてAIモデルの精度の向上を阻む要因となっているのが「過学習」だ。過学習とは、学習精度がある⼀定の精度まで向上すると、以降は未知のデータへの対応力を失ってしまう現象。AIの学習能力が低下して期待する学習結果が得られなくなってしまう。

この課題に対応するため、従来のニューラルネットワークでは、学習に制限を設けることで過学習を回避してきた。これが従来のコンピュータにおける機械学習の課題のひとつとなっていた。

今回の発表は、量子コンピュータを用いた機械学習では、量子の特性によって「過学習」が抑制される性質があることを実証実験と理論で検証した。従来から量子では過学習が抑えられる傾向が示唆されていたが、それを裏付ける結果を示した。

今回の論文では、電気通信⼤学の協力のもと、量子機械学習器は過学習しにくいという性質を詳細な数値実験を通して示し、その根拠となる理論を世界で初めて提示したことになる。

成果:モデルの表現力飽和とVC次元の上限値による過学習の抑制

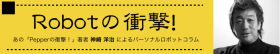

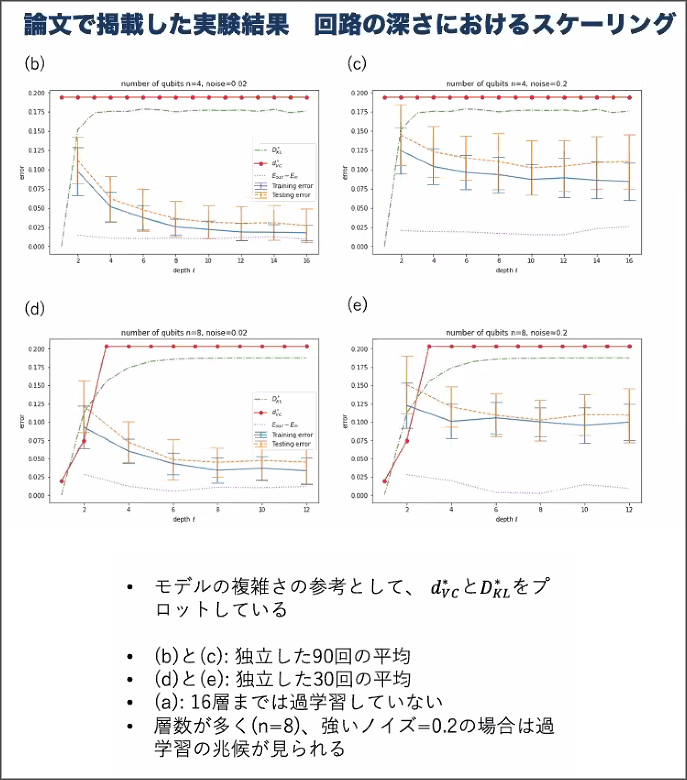

量子コンピュータは従来コンピュータとは全く異なる性質で動くため、従来コンピュータ上で成り立つ性質が、量子コンピュータでも同様に成立するのか、それとも異なる性質を持つのかが、詳細には解明されていない。そのためこの研究では、様々な量子アルゴリズムで採用されている汎用的な量⼦回路について、量⼦ビットの数と量子回路の深さなどがモデルの表現力と過学習にどう影響するかを研究した。その結果、量子回路の深さを増加させ(従来のニューラルネットワークを多層にすることに対応)パラメータを増加させると、ある地点でモデルの表現力が飽和することを、様々な数値実験で見いだしたという。モデルの表現力が飽和するということは、回路パラメータを増加させても、それ以上モデルが複雑化せず、結果、過学習が起きない事を意味する。さらに、この事実の理論保証を与えるため、モデルの複雑性の指標であるVC次元※1が上限値をもつことを証明した。このことは、訓練誤差と汎化誤差の差分の拡大が進まないことを意味し、つまり量子回路は過学習しにくいことを示す、と結論づけた。

なお、VC次元は、学習モデルが完全に分類することができる最大のデータ数を数値化したもの。

慶應義塾⼤学 量⼦コンピューティングセンター長 山本氏のコメント

今回の発表に伴い、同社は「慶應義塾⼤学 量⼦コンピューティングセンター センター⻑ ⼭本 直樹⽒のコメント」もリリースに添付している。その内容を全文紹介する。

⼭本 直樹⽒のコメント

この GRID による成果の意義を正しく理解するには、⼈⼯知能(AI)研究に関する歴史を簡単に振り返る必要があります。いうまでもなく、現在 AI は産業からエンタメまであらゆる分野で覇権をふるっています。⼀⽅で、この猛威が 3 回⽬のブームであるという事実を知っている⼈はさほど多くはないかもしれません。AI は、いままで2度の盛衰を経験しているのです。

最初の栄華は 1950 年代〜1960 年代に起こりました。AI の道具として、⼈間の脳機能を模倣するニューラルネットワーク(NN)がよく使われます。これの初期提案がなされたのがこの時代です。しかしごく簡単なタスクしかこなせないと批判され、研究は下⽕になりました。2度⽬のブームは計算機が普及してきた 1980 年代〜1990年代です。しかし NN の有効性を⽰すにはまだ計算機パワーが⾜りず、結局、またブームは去りました。現在のブームは 2006 年、NN がディープラーニングと名前を変えて華々しく再登場したことが契機でした。ついに、AI がその強⼒な情報処理能⼒を発揮するための計算機デバイスが使えるようになったのです。

ではブームの⾕間、AI 研究は真に停滞していたのでしょうか。そうではなく、まさに雌伏という⾔葉の通り、その数理的基礎研究が着々と進⾏していました。とくに、今回の成果にある VC 次元という概念が、第1次ブーム終焉後の 1971 年、当時ソビエト連邦の研究者であった Vapnik と Chervonenkis によって提案されました。これは⼤雑把に⾔うと、NN の情報処理能⼒を測るものさしです。この量が⼤きすぎる NN は過学習してしまいます。つまり、NN の情報処理能⼒が⾼すぎると、(期末試験を乗り切るために教科書を丸暗記する学⽣のように)未知データに対応できなくなってしまいます。この意味で、⼤きすぎない VC 次元をもつ NN を⽤いるべし、という重要な指針が得られたわけです。

現在華々しく利⽤されている AI を⽀えているのはこういった基礎理論で、実は、それらは⽐較的早期に発⾒されていました。例えば、NN の訓練法としていまでも標準的に使われる誤差逆伝搬法が⽢利博⼠によって提案されたのは 1966 年です。また、上記の過学習問題に対する指針のさきがけとみなせる情報量基準が⾚池博⼠によって提案されたのは 1973 年でした。Cybenko による NN の万能近似定理が証明されたのは 1989 年で、またVapnik の統計的学習理論が広く知れ渡ったのは、彼が渡⽶し AT&T に就職した 1990 年以降でした。

以上の話から、今回の成果の意義を理解することができます。量⼦計算機デバイスは、近年急速に発展していますが、まだまだ⼩さく脆弱です。しかし、規模がさらに拡⼤し、エラーが⼗分に抑えられ安定動作できるようになったら、⾊々な実問題において、量⼦計算機は現在使われている計算機を上回る情報処理能⼒を獲得するでしょう。そして AI 分野への応⽤においては、現⾏版とは全く異なる構造をもつ NN、すなわち量⼦ NN が使われることになります。すると上述した NN の事例から類推できるように、量⼦ NN の数理的基礎研究が将来の量⼦AI を⽀えることになるでしょう。事実、最近、量⼦ NN に関する重要な成果が世界中の有⼒研究機関から続々と発表されています。その中で、GRID の今回の論⽂は、量⼦ NN の VC 次元と過学習問題をはじめて正⾯から扱ったものです。素晴らしいことに、量⼦ NN は VC 次元がさほど⼤きくならず、過学習が起きにくいということが⽰唆されています。

量⼦ AI のパワーはまだ未知数です。しかし、数理的事実は不変です。将来、量⼦ NN の VC 次元をはじめて計算したのは 2021 年のあの GRID 論⽂だったね、と回顧することが楽しみです。

量子コンピュータ関連記事(ロボスタ)

株式会社グリッド

ABOUT THE AUTHOR /

神崎 洋治神崎洋治(こうざきようじ) TRISEC International,Inc.代表 「Pepperの衝撃! パーソナルロボットが変える社会とビジネス」(日経BP社)や「人工知能がよ~くわかる本」(秀和システム)の著者。 デジタルカメラ、ロボット、AI、インターネット、セキュリティなどに詳しいテクニカルライター兼コンサルタント。教員免許所有。PC周辺機器メーカーで商品企画、広告、販促、イベント等の責任者を担当。インターネット黎明期に独立してシリコンバレーに渡米。アスキー特派員として海外のベンチャー企業や新製品、各種イベントを取材。日経パソコンや日経ベストPC、月刊アスキー等で連載を執筆したほか、新聞等にも数多く寄稿。IT関連の著書多数(アマゾンの著者ページ)。