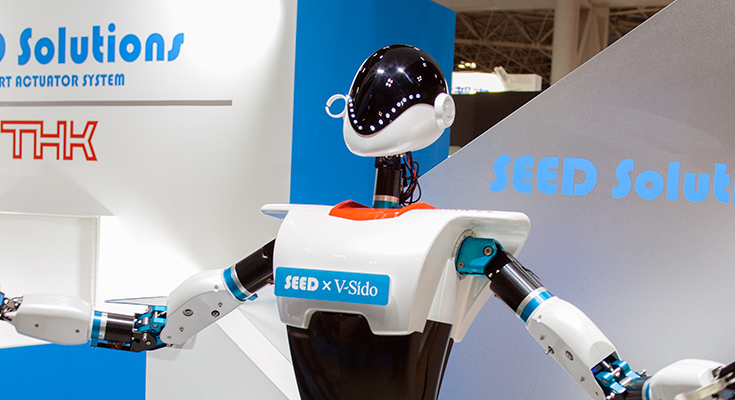

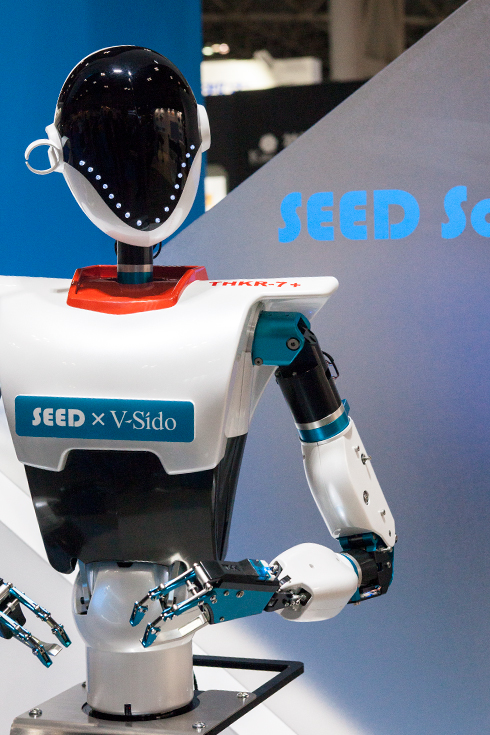

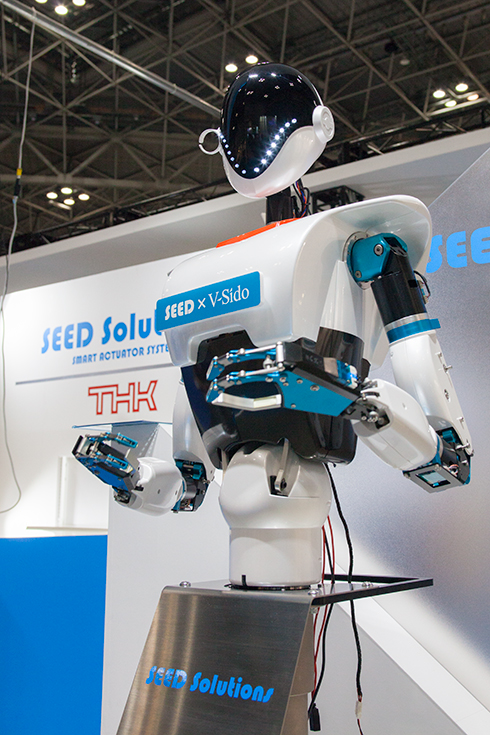

東京ビッグサイトで本日より開催中の「Japan Robot Week 2016」において、THKはロボットで利用できるスマートアクチュエータシステム「SEED Solutions」の展示を行った。その中でひときわ目を引く、THKのSEEDアクチュエータを組み込んだヒューマノイドロボットは、V-Sido OSを搭載し、新たな機能を付加した「V-Sido × Songle」(ブシドー・ソングル)によるデモンストレーションを行っていた。

アスラテックはかねてから音楽解析技術を用いて楽曲のイントロやサビ等を解析し、楽曲のメロディやワビサビに合わせてロボットがジェスチャーを自動で生成する「V-Sido×Songle」を発表している。

今年7月に開催されたPepper Worldでも、V-Sido×SongleをPepperを搭載して展示、エヴァンゲリヲンのテーマ曲をPepperの声で歌い、自動の振り付けで踊るデモを披露した経緯がある。(詳細は「【SoftBank World 2016 徹底レポート(1)】 カラオケで歌って踊れるPepper、V-Sido×Songleとボーカルのボイスエンジン搭載」)

今回、新たに追加した機能は、音声合成との連携で人間が会話で行うタイミングと同様にうなづきやブリージングなどの仕草をしたり、「さようなら」という音声とともに手を振るジェスチャーを自動で生成して実行するなど。

具体的には、例えば挨拶用のテキストを記述してロボットに話をさせる際、ロボット自身で読み上げた音声データや波形をSongle機能で解析し、ジェスチャーを自動生成する。ロボットが挨拶やプレゼンテーションをする時に自然な振る舞いで手や身体を動かしたり、ブリージングなどの生物的な何気ない動きなども付加できる。

具体的にはデモンストレーション用に挨拶文(テキスト)や、歌付きの音楽のデータを用意すると、V-Sido×Songleが挨拶の読み上げ時に文章にマッチしたロボットの動きを自動的に生成、腕を交互に動かしたら、大きく拡げたり、文章に合わせてジェスチャーを加えて来場者に話しかける。

ウェブブラウザでの操作が可能なので、振る舞いを変更したいときは、現場スタッフが比較的簡単にジェスチャーを変更することも可能。

デモでは挨拶した後、音楽が鳴りはじめると、楽曲に合わせた自動生成したジェスチャーつきの振り付けを披露(残念ながらこのヒューマノイドロボットは上半身だけなのでステップ等は踏めない)。

前回披露したPepperよりも今回のヒューマノイドロボットの方が軽快に動作していたが、これはTHKのアクチュエータを含めて、ロボットのハードウェアが機敏な動作についてくることができるため。

タイミングよく会話にジェスチャーをつけたり、音楽の振り付けを合わせるのはハードウェアの精度や性能にも依存する。

独特のデザインのヒューマノイドロボットや音楽に合わせて軽快に踊ることもあって、たくさんの来場者が足を止めて見入っていた。

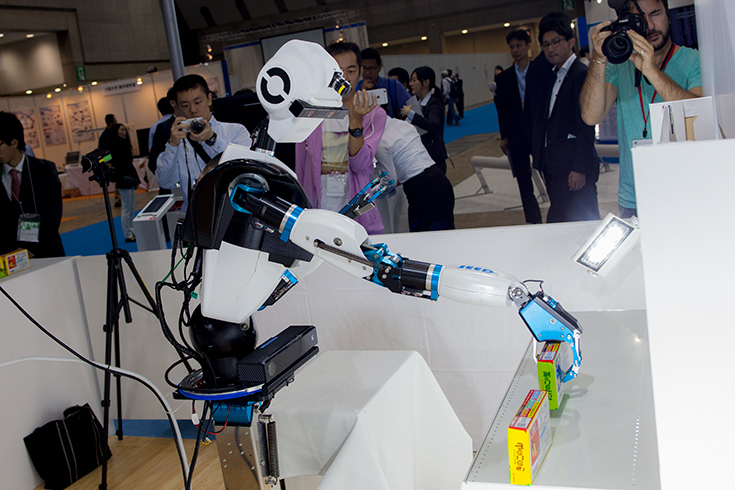

THKはその他に、アマゾン・ピッキング・チャレンジに出場したロボットシステムも展示。

東京大学稲葉研究室の研究技術を活かしたロボットが、箱やペットボトルなどの形状を判別して所定の棚に納めるデモンストレーションを公開した。

ジャパンロボットウィークは10月21日(金)まで東京ビッグサイトで開催される。